Mit Robot-Vision-Systemen, der Kombination aus Robotik und Bildverarbeitung, lassen sich mittlerweile anspruchsvolle Prozesse automatisieren. Komplexe Vision-Software verhilft dem einst blinden eisernen Gesellen zu wahren Meisterleistungen in der Fertigungslinie.

Von unserem Redaktionsmitglied Uwe Böttger uwe.boettger@konradin.de

Die Roboter im Volkswagenwerk in Wolfsburg schneiden und schweißen blind. Allerdings nur auf den ersten Blick. Denn für blinde Roboter, die auf gut Glück ihre Arbeit verrichten, ist in der modernen Fertigung kein Platz. Und in der Automobilbranche schon dreimal nicht.

Die Kollegen aus Blech sind nicht nur in Wolfsburg an der Fertigung des neuen Golf beteiligt, sondern in allen Werken, wo das neue VW-Produkt vom Band läuft. Unter anderem schneiden die Roboter die so genannten Längsträger, auf denen die Karosse schrittweise aufgebaut wird, korrekt ab. Im Prozess werden die Träger auf Übermaß gefertigt und erst am Ende auf das Maß gekappt, das genau zum gefertigten Fahrzeug passt.

Das Schneiden der Längsträger erfolgt mit einem robotergeführten Laserschneider. Obwohl sich Laser und Längsträger frei im Raum befinden, erfolgt der Schnitt auf 0,1 mm genau – wie von Geisterhand geführt. Doch da es im Werk Wolfsburg erwiesenermaßen nicht spukt – auch nicht in der Geisterschicht – müssen die genauen Instruktionen von anderer Stelle zum Roboter gelangen. Das genaue Maß berechnet ein Bildverarbeitungs-System der Isra Vision Systems AG in Darmstadt.

Die dafür notwendigen Kameras sitzen an beiden Seiten der Karosse mit Blick auf den Kotflügel. Anhand einer Nullbohrung wird das erforderliche Längenmaß der Träger ermittelt und anschließend mit weiteren Kameras die Position der Trägerenden im Raum berechnet. Mit diesen Daten wird der Roboter gefüttert. Danach setzt der stählerne Kollege zu einem chirurgischen Schnitt an, der den Längsträger genau an der Stelle kappt, die zu dem gerade gefertigten Fahrzeug passt.

An dieser Stelle des Fertigungsprozesses geht es aber erst richtig los: Auf die abgesägten Längsträger muss nun die so genannte Schottplatte gesetzt werden. Dabei handelt es sich um das Montage-Element, das letztendlich das Frontmodul des Golf mit den Längsträgern verbindet. Nachdem sich der Roboter die Schottplatte automatisch gegriffen hat, ermittelt wiederum ein Vision-System von Isra die genaue Position der Schottplatte im Greifer. Zudem werden Referenzpunkte der Schnittkante des Längsträgers im Raum berechnet. Da der Träger innen hohl ist, beschreiben die Koordinaten eine Kontur. Ausgestattet mit diesen hochgenauen Informationen, fügt der Roboter die Schottplatte an den Träger. Danach wird durch das Montage-Element hindurch geschweißt – auf den ersten Blick sozusagen blind. Doch in Wirklichkeit hat der Roboter die Szenerie genau „vor Augen“.

Es kann passieren, dass der Schneidroboter trotz genauer Daten schlechte Arbeit leistet und der Schnitt beispielsweise eine leichte Schräglage erfährt. Für das nachfolgende Schweißen denkbar schlechte Voraussetzungen, denn für die Qualität des Schweißprozesses ist der Abstand zwischen Schweißwerkzeug und Bauteil relevant. Kein Problem, denn die Schneidqualität wird vom Vision-System geprüft. Dadurch lässt sich bei Bedarf das Schweißen der Schottplatte im Prozess korrigieren. Mit anderen Worten: Hat der Schneidroboter schlechte Arbeit geleistet, erfährt das umgehend der Schweißroboter, der den Fehler wieder ausbügelt.

„Diese Anwendung ist hochkomplex“, erklärt Gabriele Jansen, Division Manager bei Isra. „Ohne die Kombination aus Robotertechnik und Bildverarbeitung wären viele Fertigungsschritte nicht zu automatisieren.“ Erst die Software der Bildverarbeitungs-Profis aus Darmstadt haucht den Robotern in Wolfsburg und anderen VW-Werken das Wissen ein, das sie für ihre tägliche Arbeit in der Fertigung brauchen: Länge, Breite, Höhe und Verdrehung in sechs Freiheitsgraden.

Es ist noch nicht so lange her, dass diese so verschieden anmutenden Techniken zusammengefunden haben: Auf der einen Seite die robusten Roboter, die schwere Werkstücke wuchten oder inmitten des Funkenflugs ihre Schweißarbeiten verrichten. Auf der anderen Seite die damals noch sehr sensible Bildverarbeitung, die schon ein Sonnenstrahl, der sich durch das Oberlichtfenster der Fertigungshalle verirrt hatte, durcheinander bringen konnte. Ende der achtziger Jahre wurde dem Roboter zum ersten Mal eine Brille auf die Nase gesetzt. Der neuen Technik-Synergie wurde zunächst der Name Robot-Guidance verpasst. Heute spricht die Fachwelt von Robot-Vision-Systemen, wenn Roboter und Bildverarbeitung zusammenarbeiten.

Wer glaubt, die Roboterhersteller haben sich mit der Bildverarbeitungs-Branche zusammengetan, um ihre Roboter zu verbessern, der irrt. Ebenso ist die Annahme falsch, dass die Vision-Hersteller nach neuen Einsatzmöglichkeiten für ihre Systeme und deswegen die Nähe der Roboter-Firmen suchten. „Das klingt zwar schmeichelhaft für beide“, lächelt Jansen. „Doch der eigentliche Anstoß für die Zusammenarbeit kam wie so oft vom Anwender.“ Um eine Produktion schneller, zuverlässiger und wirtschaftlicher aufzubauen, war irgendwann nicht nur der Roboter erforderlich, sondern zusätzlich eine Roboterführung.

Die ersten Unternehmen, die diesen Gedanken technisch umsetzten, kamen aus dem Elektronik- und Halbleiter-Bereich. Dort wurden schon seit Urzeiten Leiterplatten mit „normalen“ Robotern bestückt. Oder die eisernen Gesellen nahmen die zersägten Einzelstücke eines Wafers auf, um sie zu montieren und daraus Elektronik-Komponenten herzustellen. Im Laufe der Zeit wurden die Prozesse schneller, die Bauteile kleiner und die Anforderung an die Positioniergenauigkeit höher. Mit einer reinen Roboterlösung hat das irgendwann nicht mehr funktioniert. Dem Roboter musste unter den Arm gegriffen werden: Mit Hilfe eines Vision-Systems wurden die Lagen der Leiterplatten und der Bauteile hochgenau bestimmt und anschließend die Koordinaten an den Roboter überspielt.

Der endgültige Durchbruch der sehenden Roboter kam mit dem Schritt von 2D- zu 3D-Anwendungen. In der Elektronik spielte sich alles in zwei Dimensionen ab. Zudem waren die Bauteile relativ genau vorpositioniert. Jansen: „Mit fortschreitender Entwicklung der Bildverarbeitung gingen die Robot-Vision-Systeme raus aus der Ebene und eroberten sozusagen den Raum.“ Neue Applikationen taten sich auf. Es ließen sich Prozesse automatisieren, bei denen die Lage der Bauteile im Raum in sechs Freiheitsgraden nicht bekannt sind.

Zu diesem technischen Quantensprung hat die Bildverarbeitung maßgeblich beigetragen. Um immer komplexer werdende Aufgaben lösen zu können, waren immer bessere Erkennungsstrategien für das Vision System erforderlich. Inzwischen hat Robot-Vision den Sprung in die 3D-Welt vollzogen. Jansen: „Wenn ich alle Prozesse und jegliche Depositionierung im Raum zulasse, dann bin ich bei großformatigen Bauteilen und einer Vielzahl von Bearbeitungsschritten.“

Heute sind Lösungen möglich geworden, die noch vor kurzem undenkbar waren. Beispielsweise das automatische Fügen von Auto-Scheiben. In diesem Prozess sind zwei Komponenten beteiligt, deren Positionen im Raum nicht bekannt sind: Der Scheibenausschnitt und die Scheibe. Die Scheibe selbst kann meist so genau vorpositioniert werden, dass diese Seite des Problems gelöst ist. Bei dem Scheibenausschnitt ist das nicht möglich, weil dieser in seinen Dimensionen aufgrund von Ungenauigkeiten in der Fertigung von Fahrzeug zu Fahrzeug schwankt. Ziel der Automobil-Hersteller ist es aber, ein Fahrzeug mit einer Scheibe zu liefern, die rundherum zu den Außenkonturen immer das gleiche Spaltmaß hat. Um das zu erreichen, muss gemessen werden. Erst dann ist der Roboter in der Lage, die Scheibe in gewünschter Weise einzusetzen.

Auch die Thyssenkrupp Gerlach GmbH in Homburg/Saar profitiert von einem Robot-Vision-System. Der Hersteller von Motorkomponenten produziert unterschiedliche Varianten von Kurbelwellen. Nach dem Schmieden und Abkühlen müssen die Teile für den nächsten Bearbeitungsprozess in eine definierte Lage gebracht werden. Diesen Arbeitsschritt haben die Saarländer mit einem Robot-Vision-System automatisiert. Das zugehörige Bildverarbeitungs-System liefert die Vitronic GmbH in Wiesbaden. „Das System erkennt Raumlage und Kurbelwellentyp auf dem Förderband“, versichert Peter Kuhn, Leiter Prozess Engineering Schmiede bei dem Automobilzuliefer. „Dabei wird das Messergebnis von Zunderschichten, Graten oder Schlacken nicht verfälscht.“ Auch eine Verkippung der Rohlinge aus der Vertikalen bringt das System nach eigenen Angaben nicht aus dem Takt.

Die Robot-Vision-Technologie ist eine aufstrebende Technologie. Manfred Hock vom Verband Deutscher Maschinen und Anlagenbau (VDMA), Fachabteilung Robotik und Automation, kann das bestätigen: „Schaut man sich die Aufgabenstellungen der Bildverarbeitungs-Branche in Deutschland an, dann belegt Robot-Vision mit 11,4 Prozent den dritten Platz.“ Nur zwei Anwendungsfelder nehmen einen größeren Raum ein. Hierzu zählen die Vollständigkeitskontrolle (14,1 %) und die Oberflächeninspektion von diskreten Teilen (19 %).

Roboter-Hersteller wie beispielsweise Kuka unterstützen die Zusammenarbeit mit der Vision-Branche nachhaltig. „Jede Sensorik erweitert die Möglichkeiten“, betont Gerd Hammes von der Kuka Roboter GmbH in Wilnsdorf. „Kameras sind für Roboter schon jetzt unabdingbar, viele Anwendungen würden ohne Bildverarbeitung nicht mehr funktionieren.“

Griff in die Kiste

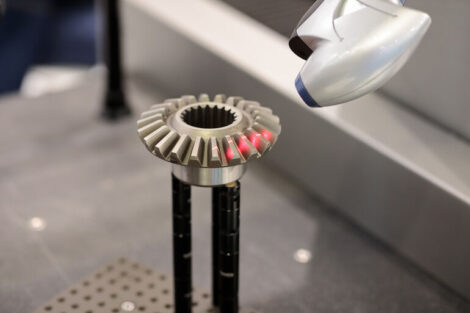

Es gibt einige knackige Begriffe in der Automatisierungstechnik, die schon seit Jahren in aller Munde sind. Der legendäre „Griff in die Kiste“ gehört dazu. Gemeint ist damit beispielsweise das Greifen von Werkstücken, die in Behältern chaotisch angeliefert und für die weitere Bearbeitung sortiert und bereitgestellt werden müssen. Dies können Kurbelwellen, Achszapfen, Buchsen oder Plastikdeckel sein. Eine Anwendung, die für Robot-Vision wie geschaffen ist.

Matthias Kossow von der Astrium GmbH in Bremen: „Die Teile liegen ungeordnet in mehreren Schichten übereinander. Das Problem lässt sich nur lösen, wenn der Roboter mit einem 3D-Sensor ausgestattet ist.“ Zur Kernkompetenz von Astrium zählt das Aufspüren von so genannten Greifpunkten. Zu diesem Zweck machen mehrere Kameras eine Aufnahme der Szene, die anschließend von einer Vision-Software unter die Lupe genommen wird. Aus der Analyse resultieren in der Regel mehrere mögliche Greifpunkte, von denen nur „der beste“ an die Robotersteuerung weitergeleitet wird. Kossow: „Die Steuerung ist der Chef und weiß, wann der Roboter Informationen braucht, wann ein Bild aufgenommen werden muss. Die Sensoren sind in Warteposition und liefern die Daten auf Anforderung.“

Teilen: