Gewiss ist Fleiß die Grundlage von Erfolg: Deshalb kommt das Eichhörnchen durch emsiges Nüssesammeln und -horten auch sicher durch den Winter. Die Jagd nach der nächsten Nuss ist ein rein automatisierter Vorgang, der immer demselben Schema folgt. Optimal ist er jedoch nicht – denn häufig vergisst das Eichhörnchen seine Verstecke. Viele gelagerte Nüsse werden folglich nie verspeist. Weil jedoch im Überfluss gesammelt wurde, überlebt das Eichhörnchen auch ohne sie.

Cleverer geht der Rabe vor: Er optimiert die Futterbeschaffung und -lagerung kontinuierlich und baut sogar Erfahrungen in sein zukünftiges Vorgehen ein. So werden beispielsweise Werkzeuge, die ihm in der Vergangenheit bei der Beschaffung behilflich waren, künftig schon Stunden vorher für den Einsatz gesucht und bereitgelegt. So spart er beim nächsten Mal Zeit und Kraft. Prozessoptimierung in Reinkultur.

Vom Raben lässt sich lernen: Es kommt nicht darauf an, große Datenmengen und Informationen zu erheben und zu sammeln, sondern sie richtig einzusetzen. In der Fertigungsindustrie gilt dies ebenso, um vorausschauende Wartung, automatisierte Qualitätssicherung oder eine ganzheitliche und nachhaltige Optimierung der Produktion zu ermöglichen.

Datensammeln nach Zielsetzung

Grundsätzlich macht es Sinn, jedwede im Unternehmen anfallenden Daten zu sichern und in Form einer strukturierten Auswertung abrufbar zu machen – auch über lange Zeiträume hinweg und für verschiedenste Fragestellungen.

Folgerichtig haben deshalb viele Unternehmer in den letzten Jahren umfangreiche Projekte zur Datensammlung, -aufbereitung und -auswertung gestartet. Ob diese mit Erfolg gekrönt sind, hängt entscheidend von einer Frage ab: Gelingt es, die Datenanalyse so in die Geschäftsprozesse zu integrieren, dass auf ihrer Basis ab sofort operative Entscheidungen automatisiert getroffen werden können?

Häufig ist das heute noch nicht der Fall. Ernüchterung stellt sich ein: Trotz des mit Analytics verbundenen großen Aufwands will es nicht gelingen, die wachsenden Datenmengen wirklich nutzbringend und nachhaltig zur Optimierung der Kernprozesse zu verwenden. Hauptursache hierfür ist eine große Lücke zwischen Daten- und Geschäftsverständnis. Datenanalysen bringen zwar durchaus relevante Erkenntnisse, diese passen aber nicht zu den aktuellen unternehmerischen Herausforderungen – oder denen des Tagesgeschäfts.

Erfolgreiche Unternehmen passen daher die etablierten Vorgehensweisen zur Nutzung von Analytics an ihre individuellen Gegebenheiten und Zielsetzungen an. Der erwartete Geschäftsnutzen wird klar ausformuliert und kommuniziert. Ebenso der vorhandene Investitionsrahmen. Und: Basis für ein erfolgreiches Projekt ist in jedem Fall eine stringente Analyse der eigenen Geschäftsprozesse.

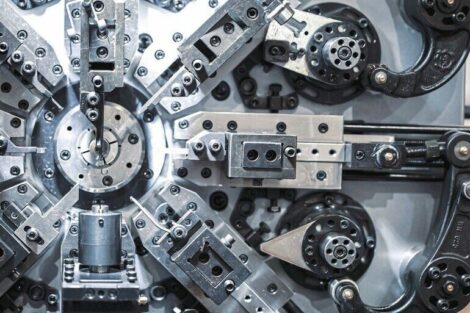

Wie erfolgreich und nutzbringend der richtige Einsatz von Analytics in der Praxis aussehen kann, zeigt das Beispiel eines namhaften Automobilzulieferers. Sein Ziel ist es, die Fertigungsprozesse auf Basis von Analytics kontinuierlich zu verbessern.

Der Einsatz von Analytics setzt immer eine Datenbasis, etwa ein Data Warehouse, voraus, in der sämtliche Daten wie beispielsweise Maschinendaten und betriebswirtschaftliche Daten, wie etwa Chargen oder Artikelstammdaten aus ERP und MES, zusammenlaufen und damit miteinander kombiniert auswertbar gemacht werden. Deshalb wurde im ersten Schritt für deren Aufbau ein Spezialist für Modellierungsprojekte an Bord geholt: MID aus Nürnberg.

Analytics mit Data Vault-Methode schafft Nutzwert beim Automobilzulieferer

Das Beratungshaus nahm die Datenmodellierung – und damit die Abbildung sämtlicher relevanter Prozesse und Objekte – nach der Data Vault-Methode vor. Deren Stärke ist eine hohe Flexibilität bei Erweiterungen, eine vollständige Historisierung der Daten und sie ermöglicht eine starke Parallelisierung der Datenladeprozesse.

Grundprinzip von Data Vault ist die strikte Trennung von Schlüsseln (Hub-Tabellen), deskriptiven Attributen (Satellit-Tabellen) und Beziehungsinformationen (Link-Tabellen) (siehe Infokasten). Durch diese Art der Modellierung sind Änderungen flexibel möglich, so dass bei Änderungen normalerweise keine bestehenden Tabellen angepasst werden müssen. Stattdessen können im Bedarfsfall einfach neue Tabellen – zum Beispiel neue Attribute als Satellit – hinzugefügt werden.

Für den Aufbau des Data Warehouse wurden zunächst die relevanten Fertigungsprozesse identifiziert und modelliert – und im Anschluss daran auch der entsprechende Datenfluss in den Prozessen. Das eigentliche Analytics-Projekt konnte mit der Fertigstellung des Data Warehouse an den Start gehen und lässt sich in folgende Phasen gliedern:

- Schwachstellenanalyse, um Optimierungspotenziale in der Fertigung aufzudecken

- Untersuchung der Ursachen für die identifizierten Schwachstellen

- Aufbau analytischer Modelle mit dem Ziel der Optimierung

Dazu werden algorithmische Verfahren (Machine Learning) eingesetzt, die Zusammenhänge zwischen den Eingabe- und Ausgabedaten erkennen.

Der Mehrwert mathematischer Modelle

Das Praxisbeispiel zeigt deutlich, wie mathematische Modelle Unternehmen erhebliche Mehrwerte bieten können. Dreh- und Angelpunkt für einen geschäftlichen Mehrwert sind die Entscheidungen in den Prozessen. Zum Beispiel, wann eine Anlage gewartet werden soll (vorausschauende Wartung) oder mit welcher nächsten Maßnahme ein Kunde im Verkaufsprozess weiter begleitet werden soll (Next-best-Action).

Deshalb sollte die Analyse der relevanten Daten zum grundsätzlichen Bestandteil aller Geschäftsprozesse werden. Dann wäre es sogar möglich, operative Entscheidungen zu automatisieren. Das bedeutet: Prozesse und Daten müssen mit einer rigiden Methodik so konzipiert werden, dass die Ergebnisse eines automatisierten Entscheidungsmodells die Prozesse treiben. Bei vorausschauender Wartung wird beispielsweise durch einen Entscheidungsautomat der Wartungs- und Instandsetzungsprozess initiiert und durchgeführt: also etwa Bereitstellung eines Serviceteams, Bestellung von Ersatzteilen oder Neuplanung der Produktion.

Hier bieten sich als Grundlage BPMN (Geschäftsprozessmodellierung) und DMN (Entscheidungsmodellierung) an. Mit Hilfe dieser Methodiken lassen sich die gefundenen analytischen Modelle bezüglich des Prozessablaufs und der Datenbewirtschaftung passgenau integrieren. Und so funktioniert es: Zum einen werden Entscheidungspunkte in den Prozessen transparent dargestellt. Zum anderen werden Entscheidungsmodelle aufgebaut, um zu erklären, warum und wie das analytische Modell an dieser Stelle den Prozess verbessert. Zudem werden die für das analytische Modell benötigten Daten dokumentiert.

Iterativ können dann – im Wechselspiel zwischen der Prozessgestaltung und den entdeckten Optimierungspotenzialen – aus den Datenanalysen Prozesskennzahlen, wie etwa Auftragsdurchlaufzeit oder Maschinenauslastung, nachhaltig verbessert werden.

Seit Projektabschluss konnte der Automobilzulieferer deutliche Verbesserungen erzielen: So lassen sich fehlerhafte Teile anhand von Fertigungsdaten frühzeitiger identifizieren. Die Produktionsplanung lässt sich hinsichtlich der Durchlaufzeiten optimieren. Überdies wurde die Gesamtanlageneffektivität erhöht.

Daten sammeln lohnt sich also in jedem Fall. Denn nur wer viele Daten hat, kann dem Management Kennzahlen und Auswertungen für Einzelfallentscheidungen zur Verfügung stellen. Ziel jedoch sollte es sein, dass möglichst viele solcher Managemententscheidungen in Zukunft automatisiert und quasi „wie am Fließband“ getroffen werden. Erst dann hat Analytics seinen echten Mehrwert erreicht.

Datenmodellierung mit Data Vault-Technik

Einteilung aller zu einem Objekt gehörenden Informationen in drei strikt voneinander getrennte Kategorien eingeteilt und.

- Kategorie „Hub“ = Informationen, die ein Objekt eindeutig beschreiben beziehungsweise ihm seine Identität geben (beispielsweise Kundennummer)

- Kategorie „Satellit“ = Attribute, die ein Objekt beschreiben (beispielsweise Kundenname)

- Kategorie „Link“ = Daten, die Beziehungen zwischen Objekten beschreiben (beispielsweise Zuordnung eines Kunden zu einer Branche oder einem gekauften Produkt).