Dass Daten das neue Öl sind, ist seit einigen Jahren eine gängige Redewendung auf allen Tech-Konferenzen. Wenn sie schnell und intelligent ausgewertet werden, lassen sie sich quasi als Treibstoff für das Unternehmensschiff nutzen.

Die Botschaft ist mittlerweile in den Firmen angekommen. Es gibt Beispiele aus der Fertigungsbranche, die zeigen, was sich erreichen lässt, wenn relevante Daten analysiert werden – auch mithilfe von Künstlicher Intelligenz.

So wertet zum Beispiel Bodenbelaghersteller Shaw Daten von Maschinensteuerungseinheiten und Scada-Systemen aus und verknüpft diese mit Auftragsinformationen. Das Unternehmen nutzt dafür Software des IT-Anbieters Splunk. Dieser verspricht, Daten aus den Produktionsprozessen und aus anderen relevanten Unternehmenssystemen auf einfache Weise zusammenzubringen, sie zu analysieren und darin Auffälligkeiten zu entdecken, die auf Fehler in der Fertigung hindeuten – und dies in Echtzeit.

Speziell für Industrie-Umgebungen hat Splunk eine Lösung entwickelt, die Informationen aus Steuerungssystemen sowie Maschinensensoren verarbeitet. Bestandteil des Angebots ist auch ein Machine-Learning-Toolkit, um Algorithmen für Prognosen, Anomalieerkennung und Clustering zu nutzen.

Überblick in Echtzeit

Bei Shaw war die Zahl der Datenquellen so groß, dass es vor dem Einsatz der Analyse-Software manchmal schwierig gewesen sei, ein Verständnis für die aktuelle Leistung in der Fertigung zu erhalten, berichtet Gabriel Gerges, Department Manager bei Shaw.

Das hat sich nun geändert. „Statt herauszufinden, dass vor zwei Stunden etwas falsch lief, das zu Qualitätsproblemen geführt hat, können wir mithilfe von Splunk auf Daten in Echtzeit zurückgreifen und sehen, wie unsere Maschinen zu jeder Zeit laufen“, so Gerges.

Der Einsatz der Datenanalyse zahlt sich aus. Shaw habe dank der Software-Unterstützung die Qualität seiner Produkte um mehr als 200 % gesteigert – so die Aussage von Seems Haji, die bei Splunk das Produktmarketing für IoT und Business Analytics verantwortet.

BMW will ebenfalls von solchen Vorteilen profitieren. Der Autobauer analysiert die Testprotokolle in seiner Fahrzeugproduktion mithilfe von Splunk. Die Auswertung zeigt, an welcher Stelle im Fertigungsprozess häufig Fehler auftreten. Anhand der Muster, die dabei auffallen, lassen sich dann Empfehlungen für Nacharbeiten in der Fertigungslinie erstellen.

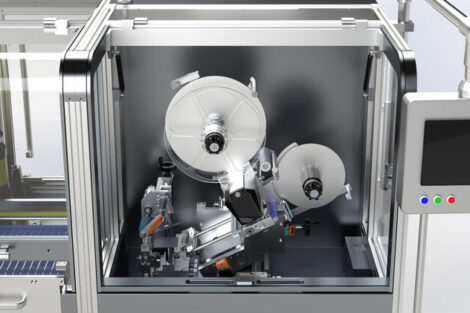

Datenanalyse in Verbindung mit Künstlicher Intelligenz ist auch bei Mettler Toledo im Einsatz. Der Hersteller von Präzisionswaagen nutzt die Möglichkeiten, um die Anwender seiner Produkte zu unterstützen.

Externe Faktoren wie Vibration, Temperatur oder sogar ein einzelner Luftzug können die Genauigkeit der Waage beeinträchtigen, deren Messergebnisse etwaige Qualitätsprobleme beim Endprodukt anzeigen sollen. Im konkreten Fall werden nun die an der Präzisionswaage gesammelten Qualitäts-, Gewichts- und Schwingungsdaten in Echtzeit in eine Cloud-Anwendung von IBM übertragen, in der mit Hilfe eines eigens für Mettler Toledo entwickelten Machine-Learning-Modells analysiert wird, ob die Präzision der Messung ungestört ist. Besteht die Gefahr, dass die Waage falsche Ergebnisse liefern könnte oder die Messergebnisse von der Norm abweichen, wird automatisch der Produktionsverantwortliche informiert.

Servicetechniker schneller vor Ort

Auf Störungen will auch Kone frühzeitig reagieren können. Daher setzt der Aufzughersteller schon seit geraumer Zeit sowohl Machine-Learning-Technologie von IBM als auch von Salesforce ein. Mittlerweile habe das Unternehmen sein Servicenetzwerk mit KI-Technologien ausgebaut, berichtet Frank Engelhardt, Vice President Enterprise Strategy bei Salesforce.

So ist nicht nur der jeweils am besten geeignete Servicetechniker bei Störungen schneller vor Ort und bereits vorab über mögliche Ursachen informiert. Frühwarnzeichen für mögliche bevorstehende Ausfälle würden nun auch intelligent erkannt und per automatisch erzeugten Wartungs-Tickets sichtbar gemacht. „So wird künftig die ungeplante Unterbrechung zur unwahrscheinlichen Seltenheit werden“, sagt Engelhardt.

Wer auf Eigenentwicklung oder generische KI-Modelle setzt, um sich diese Möglichkeiten zu erschließen, muss allerdings laut Engelhardt neue Kompetenzen aufbauen und gegebenenfalls hohe Investitionen tätigen. Einfacher geht es seiner Meinung nach mit „KI für alle“ – bereits „in die Anwendung prozess-spezifisch eingebaute Fähigkeiten“, wie sie etwa die Salesforce-Technik Einstein biete.

Engelhardt spricht in diesem Zusammenhang auch von Augmented Intelligence statt von Artificial Intelligence. Gemeint sei damit, „dass die von eingebetteten Machine-Learning-Algorithmen smart gemachten Anwendungen und Geräte spezifische Aufgaben nicht komplett eigenständig erledigen und den Menschen nicht ersetzen, sondern dessen Möglichkeiten erweitern.“

Zuerst muss aufgeräumt werden

Unabhängig davon, wie die Intelligenz nun bezeichnet wird, die zum Einsatz kommt – eine wichtige Voraussetzung für den Erfolg sind die zur Verfügung stehenden Daten. Deren Qualität muss laut Engelhardt bei allen Machine-Learning-Szenarien gut sein, „was typischerweise für ein Unternehmen zunächst Aufräumarbeit erfordert“.

„Maschinendaten sind quasi super messy“, sagt auch Matthias Maier, Technologie-Experte bei Splunk. Will heißen: Sie sind unstrukturiert und liegen in unterschiedlichen Formaten vor. Dass sich mit Splunk alle Informationen verarbeiten lassen – egal in welcher Form sie vorhanden sind – hebt er daher als großen Vorteil der Technologie hervor.

Doch trotzdem wird der Großteil der Zeit in einem Datenanalyse-Projekt darauf verwendet, die Daten verfügbar zu machen und in das richtige Format zu bringen. Das berichten selbst Splunk-Anwender.

Manchmal gibt es jedoch nicht zu viele, sondern zu wenige Daten. Das berichtete zum Beispiel Professorin Birgit Vogel-Heuser, Leiterin des Lehrstuhls für Automatisierung und Informationssysteme an der TU München, auf dem Tec Summit des VDE. Sie sprach dort über ein Projekt, in das ihr Lehrstuhl involviert war. Dabei sollten Daten analysiert werden, um die Wartung von Regelarmaturen zu optimieren. Ziel war es, den Ausfall von Ventilen zu prognostizieren.

„In einer Anlage sind jedoch nicht genügend Ventile vorhanden, um damit eine Datenanalyse zu betreiben“, so Vogel-Heuser. Das Projektteam bezog daher auch die Daten anderer Anlagen und von allen involvierten Partner wie IT-Anbieter, Sensorhersteller oder Maschinenbauer in die Auswertung mit ein.

Dies war einer der Gründe, weshalb das Projekt Erfolg brachte. Der Ausfall der Ventile lässt sich hervorsagen. Das reduziert unter anderem die Kosten für die Wartung, weil diese nur noch durchgeführt werden muss, wenn sie tatsächlich notwendig ist.

Nur wenn Informationen über Lieferketten hinweg und mit Mitbewerbern geteilt würden, entstünden echte Vorteile, sagt Vogel-Heuser. „Geteilte Daten sind zwar ein Risiko, sie bieten aber auch Chancen für bessere Modelle.“

Die Politik ist gefordert

Der VDE (Verband der Elektrotechnik, Elektronik und Informationstechnik) macht sich Sorgen über Deutschlands Innovationskraft. Künstliche Intelligenz (KI) und entsprechende Anwendungen seien zwar das technische Top-Zukunftsthema. Vom VDE befragte Experten zweifeln jedoch am Entwicklungsstand bei der Erforschung von KI in Deutschland und Europa. Nur drei Prozent sehen hier Deutschland als Vorreiter. Spitzenreiter in KI sind dagegen die USA (59 Prozent), China (39 Prozent) und Israel (31 Prozent), gefolgt von Japan und Süd-Korea mit jeweils 17 Prozent.

„Es ist kein Geheimnis, dass die USA und China die Erforschung von KI massiv mit hohen Summen fördern“, sagt Ansgar Hinz, CEO des VDE. In Deutschland werde stattdessen erst mal lange diskutiert. „Die Politik muss endlich aufwachen und die Weichen dafür stellen, dass Unternehmen schnell und unbürokratisch gefördert werden“, so Hinz. Für die Studie wurden 77 Experten, Manager, Forschungschefs und Hochschulprofessoren befragt.

Hier finden Sie mehr über: