Industrie 4.0 und die Digitalisierung sind aus Zukunftsstrategien vieler Unternehmen nicht mehr wegzudenken. Die datenbasierte Vernetzung der eigenen Produktion und damit die durchgängige Umsetzung einer Industrie-4.0-Fabrik stellt die meisten Firmen aber vor große Herausforderungen. Oft mangelt es am notwendigen übergreifenden Verständnis und an einer klaren Herangehensweise, um mit der Implementierung zu starten. Das Werkzeugmaschinenlabor WZL der RWTH Aachen hat daher ein Vorgehen erarbeitet und gemeinsam mit Praxispartnern umgesetzt, mit dem produzierende Unternehmen die Möglichkeiten der Digitalisierung gezielt für sich nutzbar machen können.

In nur drei Hauptschritten kann sich ein Unternehmen sein individuelles, datengestütztes Produktionskonzept erstellen, durch das ganzheitlich Daten erhoben, verarbeitet und visualisiert werden. Angelehnt ist das Vorgehen an die am WZL entwickelte Infrastruktur des Internet of Production (siehe Bild rechts), durch die eine echtzeitfähige Bereitstellung von Informationen auf dem erforderlichen Aggregationsniveau in Form eines digitalen Schattens der Produktion ermöglicht wird.

Schritt eins: Systematische Datenanalyse

Bei der unternehmensindividuellen Umsetzung dieser Infrastruktur unterstützt ein dreischrittiges Vorgehen zur Konzeption einer Industrie-4.0-Infrastruktur (siehe Bild). Auf Basis der benötigten Entscheidungsbedarfe wird eine systematische Datenanalyse durchgeführt und als Grundlage für eine hard- und softwareseitige Umsetzung genutzt. Zunächst geht es darum, die grundsätzlichen Entscheidungsbedarfe zu identifizieren. Dafür muss bestimmt werden, welche Entscheidungen von welchen Funktionen im Unternehmen getroffen werden und welche Informationen für diese durch die Infrastruktur bereitgestellt werden sollen. Darauf basierend lässt sich ein unternehmensspezifisches Datenmodell erstellen, das die Basis für die Infrastruktur bildet.

Schritt zwei: Ist-Datenanalyse per Datenwertstrom

Nachdem die Entscheidungsbedarfe und das Datenmodell definiert sind, ermittelt im zweiten Schritt die Ist-Datenanalyse, welche Informationen oder Daten im Detail für die Entscheidungen in welcher Datengranularität benötigt werden und welche beispielsweise in IT-Systemen, Maschinen oder Sensoriken bereits aktuell verfügbar sind. Konkret lässt sich dies mittels eines sogenannten Datenwertstroms bewerkstelligen. Hierzu werden parallel zum normalen Wertstrom alle Daten identifiziert, die im Verlauf der Gesamtabwicklung aus den verschiedenen Bereichen Produktion, Qualitätssicherung oder etwa Logistik anfallen, verarbeitet und verwendet werden. Hierbei geht es nicht nur um die Frage, welche Daten zur Prozessregelung, sondern auch als Dokumentationsgröße, Überwachungsgröße oder für Analysezwecke benötigt werden oder potenziell nützlich sein könnten. Um eine aufwandsgerechte Abbildung zu ermöglichen, ist die Bestimmung des richtigen Aggregationsniveaus (etwa Datenmenge und Frequenz der Aufnahme) hier unumgänglich. In Form einer Gap-Analyse lassen sich zum Ende des Schrittes alle notwendigen Handlungsbedarfe ableiten.

Dritter Schritt: Hard- und softwareseitige Umsetzung

In der hard- und softwareseitigen Umsetzung ist es notwendig, die Prozessschritte parallel und iterativ zu bearbeiten. Zur gezielten, hardwareseitigen Erzeugung, Verarbeitung und Bereitstellung von Informationen oder Daten bieten sich eine breite Technologierecherche und gleichzeitig ein Hinterfragen der bestehenden Maschinen und Systeme an. Geführt vom Informationsfluss ist es notwendig, einen kompletten Datenfluss von der Quelle der Entstehung bis zur Visualisierung hardwareseitig zu ermöglichen. Dafür müssen Maschinen und Sensoriken eingesetzt oder eingebracht werden, Datenübertragungsmöglichkeiten bewusst zwischen kabellos und mit Kabel definiert werden, Rechnerkapazitäten zentral und dezentral an den Maschinen zur Aggregation und Analyse bereitgestellt werden und Visualisierungsmöglichkeiten (etwa per Tablet, Monitor oder Brille) gefunden werden.

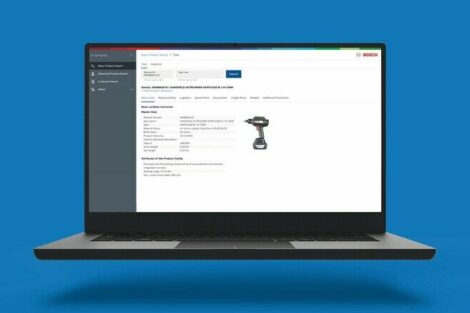

Umsetzung als Grundlage für nutzerspezifische Apps

Für die softwareseitige Implementierung stehen neben der reinen Programmierung die Fragen der Datenverarbeitung und -analyse durch beispielsweise statistische Methoden oder durch künstliche Intelligenz und besonders der Entwurf der Datenvisualisierung im Mittelpunkt. Da die hier entwickelte Dateninfrastruktur letztlich den einzelnen Akteuren als eine möglichst intuitive und verständliche Entscheidungs- und Kontrollunterstützung dienen soll, ist eine Zusammenarbeit mit den späteren Anwendern zum Entwurf der Benutzeroberflächen mittels funktionalen und designtechnischen Prototypen essentiell. Durch eine stringente Umsetzung entsteht die Grundlage für nutzerspezifische Applikationen (siehe Bild) in der Produktion, die aggregiert und in relativer Echtzeit alle wichtigen Informationen für den jeweiligen Anwender bereitstellen.

Grundsätzlich ermöglicht dieses systematische Vorgehensmodell den pragmatischen Aufbau einer unternehmensindividuellen Industrie-4.0-Infrastruktur. Durch diese können die Fach- und Führungskräfte durch die Bereitstellung von fallspezifischen Daten in relativer Echtzeit befähigt werden, besser schnellere Entscheidungen zu treffen.